Se da un lato le iniziative editoriali in corso offrono la possibilità di avvicinarsi alle storie di Isaac Asimov o di rileggerle, a iniziare dal celeberrimo ciclo Fondazione, dall’altro l’anno del centenario della nascita del grande scrittore e divulgatore, costituisce una ghiotta occasione per riflettere sul futuro della scienza e della tecnologia, futuro che tanta parte aveva nell’attività narrativa e divulgativa di Asimov. Partiamo da una riconsiderazione contenuta nello studio del 1962 The Genetic Code, nel quale afferma che per qualsiasi ambito scientifico, dopo una scoperta o un’invenzione rilevanti, sono necessari sessant’anni affinché dalla stessa se ne ricavino tutti i frutti possibili (cfr. Asimov, 1984).

A dimostrazione di ciò, nell’introduzione racconta che si era nel 1823 quando il fisico danese Hans Christian Ørsted comprese il collegamento fra corrente e magnetismo; passarono da quel giorno esattamente sessant’anni fino al 1883, quando vennero inventate le lampadine a incandescenza ed ebbe inizio l’elettrificazione del mondo. Asimov prosegue dicendo che, sempre nel 1883, Thomas Alva Edison scopriva l’effetto Edison e brevettava, quindi, il primo dispositivo elettronico della storia, dando il via allo sviluppo dell’elettronica moderna, che portò nel giro di altri sessant’anni alle invenzioni prima della radio e poi della televisione.

Un lasso di tempo necessario

Sessant’anni sarebbero quindi il limite di tempo teorico per rendere effettivi tutti (o quasi) i sogni che la mente umana può concepire da un’invenzione o da una scoperta. A riprova che gli esempi riportati, relativi alla velocità di evoluzione di una tecnologia a seguito di una scoperta scientifica o di un’invenzione, non sono puramente un caso, possiamo considerare l’oggetto narrativo per eccellenza della carriera di romanziere di Asimov: l’Intelligenza Artificiale. Fu nel 1950 che per la prima volta Alan Mathison Turing, il logico e matematico britannico noto per essere uno dei padri dell’informatica moderna, accostò i termini macchina e intelligenza nel suo articolo Computing Machinery and intelligence (Turing, 1950).

Turing deve la sua notorietà alla definizione del suo celebre modello di macchina calcolatrice universale, macchina alla quale diede il suo nome e a cui tutti i moderni computer si sono ispirati. La macchina di Turing costituiva una formalizzazione rigorosa di calcolo e consentiva virtualmente di poter eseguire quasi qualsiasi algoritmo con estrema precisione e affidabilità. L’articolo del 1950 riprendeva alcune sue idee incentrate sulla possibilità di poter costruire, sempre sulla base della macchina di Turing, un cervello meccanico. La domanda provocatoria che l’autore poneva era: “Le macchine possono pensare?”.

L’idea delle macchine pensanti era già stata sondata nella fantascienza di riviste pulp come Astonishing Stories e Super Science Fiction, e questo già prima del 1950. In quegli anni, riviste e magazine come questi riempivano le proprie pagine di racconti di robot e macchine che avevano come unico obiettivo quello di soppiantare la razza umana. Prima di mandare in pubblicazione il suo articolo, Turing decise allora di rielaborare il suo quesito sotto forma di test qualitativo introducendo quello che lui definì l’Imitation Game (o gioco dell’imitazione), successivamente rinominato come Test di Turing; test che consisteva nell’affermazione che se una macchina può far credere a un umano di essere anch’essa umana, allora quella macchina può essere considerata intelligente. In questo senso si faceva già strada nell’immaginario collettivo un conflitto fra un’idea negativa delle macchine intelligenti, che “imitando” l’uomo diventano una minaccia per l’individuo; e un’idea positiva, che vedeva le macchine, invece, come validi sostituti dell’uomo in grado di aiutarlo e coadiuvarlo nelle sue attività.

La robotica in forma di racconto

Asimov, che si era nutrito per tutta la sua giovinezza di storie e racconti delle riviste pulp, si rese testimone del pensiero positivo: aveva infatti sviluppato una propria idea della tecnologia e più in generale della scienza che poco spazio lasciava a macchine o invenzioni che non fossero di utilità e di aiuto per l’uomo. Questa visione ottimistica fu quella che contraddistinse nettamente la narrativa e la divulgazione asimoviana, e che influenzò la narrativa del periodo d’oro della fantascienza americana segnando un cambio di passo e di qualità nella costruzione dei romanzi e dei racconti. Asimov cercava anche di mitigare le paure della guerra fredda chiamando in causa l’inseparabile accoppiata tra l’uomo e la tecnica:

“Anche da giovane non riuscivo a condividere l’opinione che, se la conoscenza è pericolosa, la soluzione ideale risiede nell’ignoranza. Mi è sempre parso, invece, che la risposta autentica a questo problema stia nella saggezza. Non è saggio rifiutarsi di affrontare il pericolo, anche se bisogna farlo con la dovuta cautela. Dopotutto, è questo il senso della sfida posta all’uomo fin da quando un gruppo di primati si evolse nella nostra specie. Qualsiasi innovazione tecnologica può essere pericolosa: il fuoco lo è stato fin dal principio, e il linguaggio ancor di più; si può dire che entrambi siano ancora pericolosi al giorno d’oggi, ma nessun uomo potrebbe dirsi tale senza il fuoco e senza la parola”

(Asimov, 1995).

Così, dieci anni prima che Turing pensasse il concetto di macchine intelligenti, esattamente nel 1940, Asimov aveva pubblicato, sulla rivista Super Science Stories, il suo primo racconto, dal titolo Robbie (cfr. Asimov, 2019), con protagonista un robot positronico. Un robot nato per intrattenere bambini che però finisce col salvare la sua piccola padroncina da morte certa. Questo sarà l’incipit di una lunga serie di racconti e darà modo ad Asimov di introdurre le sue leggi della robotica: visioni di macchine che possono essere “domate” dall’uomo, e che anzi divengono una risorsa indispensabile per garantire non solo la sopravvivenza della specie umana, ma in molti casi anche il rispetto delle norme umane di convivenza. In questo senso nei suoi racconti saranno cruciali le figure del poliziotto Elija “Lije” Baley e del suo partner robotico R. Daneel Olivaw, che popoleranno le narrazioni dei primi tre libri del Ciclo dei Robot e altre narrazioni dell’universo fantascientifico di Asimov.

Su questo solco, fino ai primi anni Sessanta il binomio progresso – opportunità sarà dominante. Del resto nello sviluppo dell’intelligenza artificiale il confine tra saggistica e narrativa fantascientifica è divenuto sempre più labile man mano che la comunità scientifica ha cominciato a lavorare sul piano simbolico, flirtando con l’immaginario oltre che con la tecnica. Cinque anni dopo la pubblicazione dell’articolo di Turing, più precisamente nel 1955, viene coniato il termine “intelligenza artificiale”, in un documento informale di diciassette pagine noto come Proposta di Dartmouth redatto dagli informatici John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon che motivano la necessità di una conferenza che affronti il tema:

“Lo studio procederà sulla base della congettura per cui, in linea di principio, ogni aspetto dell’apprendimento o una qualsiasi altra caratteristica dell’intelligenza possano essere descritte così precisamente da poter costruire una macchina che le simuli”

(McCarthy, 1955).

Al convegno tenutosi sempre a Dartmouth l’anno successivo, nel 1956, presero parte altre importanti figure dell’epoca, dando impulso a una fitta rete di collaborazioni fra scienziati che portarono il periodo a cavallo fra la seconda metà degli anni Cinquanta e la prima metà degli anni Sessanta a essere etichettato come il periodo aureo dell’intelligenza artificiale. Il periodo d’oro della fantascienza americana preparava quindi il terreno per il periodo d’oro dello studio sull’intelligenza artificiale. Poco tempo dopo il convegno del 1956 vennero forgiati i primi sistemi basati su euristiche in grado di provare teoremi matematici, a volte con soluzioni più originali di quanto non fossero quelle già note.

Frame da Ecce Homo cortometraggio di Andrea Moneta (2017).

Frame da Ecce Homo cortometraggio di Andrea Moneta (2017).

I risultati erano impressionanti, tanto che si arrivò a concludere che la capacità dei nuovi software di pensare in modo non numerico fosse la soluzione dell’antico problema mente/corpo. Un sistema composto di materia poteva dunque avere le proprietà della mente. Un punto di rottura nell’evoluzione degli studi sull’intelligenza artificiale arrivò intorno all’inizio degli anni Sessanta, quando il filosofo inglese John Randolph Lucas, nel suo articolo Minds, Machines and Gödel (Lucas, 1961), affermò che il teorema con cui Kurt Friedrich Gödel nel 1931 aveva dimostrato che esistevano enunciati matematici di cui nessuna procedura sistematica poteva determinare la verità o la falsità poneva un limite al sogno delle macchine pensanti. La mente umana poteva continuare a crogiolarsi nella sua superiorità, perché quei paradossi invalicabili riusciva a oltrepassarli. La dualità uomo-macchina non sarebbe mai stata un binomio di enti sovrapponibili.

Il decennio degli anni Sessanta si trasformò dunque in un decennio di profonda competizione fra i ricercatori, in cui ad alcuni successi si alternarono tesi che esponevano le debolezze delle teorie alla base della ricerca. L’affermazione di Lucas stabiliva in sostanza che le macchine non sarebbero arrivate mai alla specializzazione umana. Diventava quindi insensato quel percorso di ricerca che portava a imitare la mente umana, sfruttando il groviglio delle logiche dei sistemi formali e si faceva largo il tentativo di emulare il concetto di senso comune.

I riflessi cinematografici

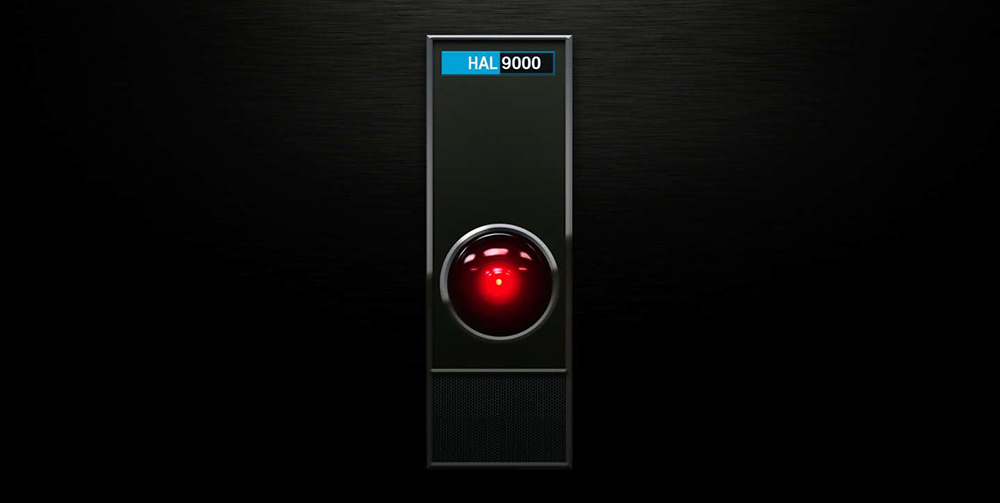

Si palesava quindi l’impossibilità di definire le macchine in maniera immediata e semplice, matematicamente comprensibile, portando quindi anche i narratori a rivalutare, almeno in parte, il modo di raffigurare le macchine pensanti: gradualmente divennero oggetti incontrollabili, insondabili nella loro complessità, oscuri, quasi magici. Il 1968 segnerà il culmine di questa visione negativa: è infatti l’anno in cui vede la luce, nel film 2001, Odissea nello spazio (Kubrick, 2007), il supercomputer HAL 9000, acronimo per Heuristic ALgorithmic (algoritmico euristico). L’obice vitreo di luce pulsante rossa, con cui il cervello elettronico viene raffigurato, bene rievoca l’archetipo tolkieniano del male, paragonabile visivamente all’occhio di Sauron. Non a caso l’obice di HAL viene denominato “occhio” anche se non definisce necessariamente le capacità visive del supercomputer. Stanley Kubrick diede mandato ai coautori di intervistare ingegneri spaziali, astronauti e scienziati cibernetici. Fra gli altri quindi venne intervistato anche Minsky, all’epoca direttore del laboratorio di IA del MIT. L’“immagine” che venne scattata fu quella di un archetipo: HAL, che ben raffigurava il contrasto fra le divergenti visioni accademiche sulle macchine pensanti negli anni Sessanta.

Nel frattempo Asimov continuava a coltivare il suo pensiero positivo verso entità non umane (e nemmeno umanoidi), come nel caso del Multivac: mastodontico calcolatore analogico che costituiva la naturale evoluzione dei calcolatori degli anni Cinquanta. Il Multivac nei racconti di Asimov subisce una evoluzione continua: da semplice calcolatore a macchina pensante, da entità cyborg (che per certi versi anticipa i complessi meccanismi della Matrix di Andy e Larry Wachowski) fino a scintilla creatrice dell’universo, come nel racconto L’ultima Domanda (Asimov, 1994). Proprio nell’anno di uscita di 2001, Odissea nello spazio Asimov dà alle stampe il suo racconto Parola Chiave (Asimov, 1976), in cui il Multivac, come HAL, ha dei malfunzionamenti incomprensibili, originati però non dalla complessità della macchina, ma dall’uomo stesso e dal suo progressivo distacco dal senso di umanità e di comprensione dell’altro da sé.

Gli anni Settanta perpetuano il clima di contrasto già esistente nella ricerca alla fine del decennio precedente, ma incoraggiano anche nuovi studi. È oramai quasi consolidata l’idea che le macchine pensanti, una volta definite, potranno facilmente ribellarsi all’uomo.

L’idea positiva coltivata da Asimov grazie alle sue leggi della robotica viene controvertita da produzioni che rimarranno nell’immaginario collettivo, come nel film di Michael Crichton Il mondo dei Robot (1973). L’ambiente accademico viene quindi influenzato anche da visioni come queste e nel 1976 Joseph Weizenbaum, professore del MIT, nel suo libro Il potere del computer e la ragione umana affermerà che la ricerca sull’IA è solo un “trastullo” distante dai bisogni della società, mettendo in dubbio anche l’etica del campo di ricerca: “Visto che non abbiamo modo di rendere saggi i computer, non dovremmo attribuire loro compiti che richiedano saggezza” (Weizenbaum, 1987).

Gli anni Ottanta sono anni ancora di studio per l’intelligenza artificiale, ma già nel 1985 nasce la prima azienda commerciale che offre software che può essere definito intelligente. Il 1985 sarà anche l’anno della svolta in cui il modello di Turing del cervello come macchina manipolatrice di simboli verrà abbandonato in favore di un modello che considera il cervello come insieme caotico di processi paralleli e sovrapposti. Gli anni Ottanta diverranno, quindi, l’epoca del primo vero studio approfondito dei sistemi di reti neurali. Sotto questa visione rinnovata in cui la definizione dei sistemi viene fondata sul modello del cervello umano e sulla base del vecchio sogno infranto di realizzare delle macchine pensanti, gli anni Ottanta saranno il decennio in cui Paul Verhoeven porterà sugli schermi il suo RoboCop (Verhoeven, 2014), entità cyborg, programmata per far rispettare la legge, che proprio grazie alla sua dualità uomo-macchina cancella in un colpo l’oscurità del reame delle macchine pensanti, e omaggia le leggi della robotica di Asimov con le sue Direttive, che mandano in crisi il cyborg non appena questo si rivolta contro i vertici dell’azienda che lo ha fabbricato.

Gli anni Novanta saranno il decennio in cui Asimov consegnerà al mondo simbolicamente il suo lascito. Lo scrittore muore nel 1992: l’ultimo decennio della sua vita era stato dedicato all’ampliamento del suo Ciclo della Fondazione, a cui aveva alternato anche l’ampliamento dell’altro Ciclo dei Robot, fino a unificare le due narrazioni, che in quattordici volumi offrono una sorta di storia del futuro, in cui, di fondo, il tema dell’intelligenza artificiale non viene mai abbandonato.

Il dopo Asimov tra realtà e immaginazione

Gli anni successivi alla morte di Asimov saranno gli anni in cui, come profetizzato da Raymond Kurzweil nel suo The Age of Intelligent Machines, le macchine sanciranno il proprio predominio nel reame ludico (cfr. (Kurzweil, 1990). Il 1996, in particolare, sarà l’anno in cui il sistema intelligente Deep Blue della IBM, già in grado di confrontarsi operativamente nel gioco con un umano, sbaraglierà il ben noto campione russo Garri Kimovič Kasparov nella celebre Partita 1, punto di svolta nel superamento delle capacità mentali umane da parte delle macchine. Questo predominio nel gioco continuerà quasi venti anni dopo, nel 2015, con il software AlphaGo: un software per il gioco del Go, sviluppato da Google DeepMind, che fu in grado di sconfiggere prima il campione europeo del gioco Fan Hui e successivamente uno dei più forti giocatori di Go al mondo, il campione sudcoreano Lee Sedol. Gli anni Novanta saranno in definitiva il periodo in cui diverrà timidamente oggetto del reale il fascino per le inesplorate e universali capacità delle macchine pensanti già ipotizzate da Turing cinquanta anni prima, una sorta di preludio alla realizzazione del cervello meccanico.

Questo decennio però, sarà anche quello di Terminator 2 di James Cameron (1991) e di Matrix (1999) dei citati Wachowski, anni in cui molti registi poco attenti dedicheranno le proprie narrazioni a quei temi che la tradizione fantascientifica ha consolidato attorno alle macchine pensanti, diventate per Hollywood il cattivo ideale del mondo post-guerra fredda. Fra le poche produzioni in controtendenza, se non unica, vi sarà proprio un film ispirato a una delle storie più celebri di Asimov: L’uomo bicentenario per la regia di Chris Columbus (1999), trasposizione del racconto omonimo di Asimov (cfr Asimov, 2019) e del successivo romanzo scritto con Robert Silverberg Robot NDR-113, in cui tutto l’ottimismo di Asimov emerge con prepotenza (cfr. Asimov e Silverberg, 1992).

I prodotti narrativi e cinematografici di quegli anni non forniranno alcun supporto alla comunità scientifica per illustrare i progressi del settore al pubblico, come invece Kubrick aveva cercato di fare. L’eredità di Kubrick viene però raccolta da Steven Spielberg, che proprio sulla base di una sceneggiatura del compianto Kubrick porta sul grande schermo nel 2001 A.I., continuazione della narrazione dell’archetipo di HAL in un futuro remoto. Ma mentre autori come Asimov sono interessati a esplorare i confini tra macchina e uomo e le conseguenze provocate da macchine che oltrepassano questi confini, gli autori di quel periodo sembrano più preoccupati della inevitabilità di questa idea.

Il XXI secolo alza il tiro

Gli anni Duemila sono gli anni in cui l’idea di affrontare il test di Turing, con le dotazioni hardware e software disponibili, diventerà preponderante: diversi team di ricerca tentano di definire sistemi idonei e le macchine iniziano a cimentarsi nella comprensione di un testo scritto e nella capacità di rispondere a domande di senso compiuto. Così nel febbraio del 2011, proprio a sessantuno anni dall’articolo di Turing, il sistema Watson della IBM partecipa al quiz televisivo Jeopardy, sconfiggendo Brad Rutter, noto come il campione che ha vinto più denaro partecipando alla trasmissione, e Ken Jennings, detentore del record di permanenza nello show. Watson rappresenta quindi il nuovo progresso degli studi sull’intelligenza artificiale, ottenuto attraverso un’ampia collaborazione oltre che dei team dell’IBM anche di studenti e ricercatori provenienti da diverse università, non solo statunitensi.

IBM descrive il sistema come un’applicazione avanzata di elaborazione del linguaggio naturale, information retrieval, rappresentazione della conoscenza, ragionamento automatico, e tecnologie di apprendimento automatico applicate al campo dell’open domain question answering (letteralmente, risposte a domande a dominio aperto, cioè senza restrizioni sull’argomento). Per il professore di filosofia all’Università della California a Berkeley, John Searle, Watson non può tuttavia essere definito realmente una macchina pensante: in base al suo esperimento mentale della stanza cinese (cfr. Searle, 1990), Watson non opererebbe altro che una mera manipolazione di simboli senza capacità di comprensione.

Dimostrazioni come quella di Watson alimentano comunque il dibattito intorno a quella che è una delle ultime profezie di Kurzweil, illustrata nel suo libro del 2005 dal titolo La singolarità è vicina, in cui viene esposta la tesi secondo cui la singolarità tecnologica si verificherà nell’arco della prima metà del XXI secolo. La singolarità viene solitamente illustrata come quel punto di non ritorno a partire dal quale i progressi tecnologici della specie umana oltrepassano le capacità di comprensione dell’individuo. Viene prefigurata, quindi, la nascita di un’intelligenza artificiale che surclasserà le capacità del cervello umano.

Gli anni Dieci del XXI secolo sono, quindi, gli anni in cui la cinematografia e la narrativa rinnovano l’interesse verso l’intelligenza artificiale, alimentando il mito della singolarità tecnologica sia in termini positivi che negativi. A questo proposito vengono messe in campo molte produzioni con prerogative e intenti differenti. Solo per citarne alcuni ricordiamo: Eva (Maíllo, 2011), Her (Jonze, 2013), Automata (Ibáñez, 2014), Ex Machina (Garland, 2015) e la serie Westworld (partita nel 2017 e tuttora in corso), basata vagamente sul citato film di Crichton. Tutte narrazioni in cui il confine fra paura e ottimismo è sempre labile e indefinito. L’eredità culturale di Asimov è divenuta, nel frattempo, un elemento fondante del mito delle macchine intelligenti: le tre leggi della robotica sono l’elemento che più di ogni altro consente di poter porre in atto quei contrasti filosofici ed etici, che per primo Asimov aveva evidenziato nella sua personale versione del futuro.

Oggi, come predetto da Asimov, a più di sessant’anni dagli avvenimenti che segnarono l’inizio della disciplina chiamata intelligenza artificiale, è iniziata l’era delle macchine intelligenti. Sono state sviluppate e sono in uso commercialmente delle intelligenze artificiali applicate ad ambiti come gli investimenti economici, o la ricerca di nuove molecole, o ancora di nuovi vaccini.

I sistemi intelligenti sono presenti in ogni campo dell’attività umana, ma come ipotizzato venti anni fa da Pat Heyes e Ken Ford dell’Institute for Human Machine Cognition di Pensacola in Florida, pochi scienziati hanno continuato a lavorare sulle macchine a imitazione dell’uomo ipotizzate da Turing e delineate da Asimov. La maggior parte degli sforzi si sono piuttosto concentrati nel costruire macchine che aumentino come una leva l’intelligenza umana esistente, rafforzando quello che viene indicato come modello cognitivo protesico. Per Hayes e Ford le più utili applicazioni per computer, tra cui quelle etichettate come IA, sono pregiate proprio in virtù della loro mancanza di umanità, intesa in accezione negativa, fatta di difetti, venalità ed emotività, differente da quella che Asimov invece cercava di ricalcare sui suoi personaggi robotici, i quali rappresentavano per lui una versione migliore dell’essere umano, pronta a definire il passo successivo nella nostra scala evolutiva.

Forse fra altri sessant’anni l’uomo riuscirà a completare l’opera di “creazione” e, come nel mito di Prometeo, consegnerà alle macchine il “fuoco” di una vera e propria coscienza.

- Isaac Asimov, Il codice genetico, Einaudi, Torino, 1984.

- Isaac Asimov, Parola chiave in Testi e note, Urania, n. 697 e 699, Mondadori, Milano, 1976.

- Isaac Asimov, I robot dell’alba, Mondadori, Milano, 1995.

- Isaac Asimov, L’ultima domanda in Il meglio di Asimov, Mondadori, Milano, 1995.

- Isaac Asimov, Visioni di robot, il Saggiatore, Milano, 2019.

- Isaac Asimov, Robert Silverberg, Robot NDR-113, Bompiani, 1992.

- Ray Kurzweil, The Age of Intelligent Machines, Mit Press, Cambridge Mass. 1990.

- Ray Kurzweil, La singolarità è vicina, Apogeo Education, 2008.

- John Randolph Lucas, Minds, Machines and Gödel, Philosophy, vol. 36, 1961.

- John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon, A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, agosto 1955.

- John R. Searle, La mente è un programma?, in Le scienze, n. 259, Roma, 1990.

- Alan Mathison Turing, Computing machinery and intelligence, Mind, vol. 59 n. 236, ottobre 1950.

- Joseph Weizenbaum, Il potere del computer e la ragione umana. I limiti dell’intelligenza artificiale, Gruppo Abele Torino, 1987.

- James Cameron, Terminator 2. Il giorno del giudizio, Cecchi Gori 2001 (home video).

- Chris Columbus, L’uomo Bicentenario, Columbia TriStar Home Entertainment, 2013 (home video).

- Michael Crichton, Il mondo dei robot, Warner Home Video 2013 (home video).

- Alex Garland, Ex Machina, Universal Pictures 2015, (home video).

- Gabe Ibáñez, Automata, Eagle Pictures 2015 (home video).

- Spike Jonze, Her, Warner Home Video, 2013 (home video).

- Stanley Kubrick, 2001 Odissea Nello Spazio, Warner Home Video 2007 (home video).

- Kike Maíllo, Eva, Eagle Pictures 2012 (home video).

- Jonathan Nolan, Lisa Joy, Westworld, HBO, 2017 – in corso.

- Steven Spielberg, A.I. – Intelligenza Artificiale, Warner Home Video 2005 (home video).

- Paul Verhoeven, RoboCop, 20th Century Fox, 2014 (home video).

- Andy e Larry Wachowski, Matrix, Warner Home Video 2000 (home video).